La inteligencia artificial sigue ampliando horizontes, y con ella crecen las demandas de cálculo que enfrentamos. Ante este contexto, exploramos a fondo la Radeon AI PRO R9700 de AMD, un modelo diseñado para responder a las necesidades de cargas locales exigentes.

Esta GPU se basa en la arquitectura RDNA 4 y emplea un nodo de 4 nm. Incorpora 64 unidades de cómputo, 4096 procesadores stream y 128 aceleradores de IA. Dispone de 32 GB de VRAM GDDR6 y un ancho de banda de 640 GB/s, lo que permite ejecutar modelos como DeepSeek R1 32B o Mistral 24B sin limitar la velocidad de proceso.

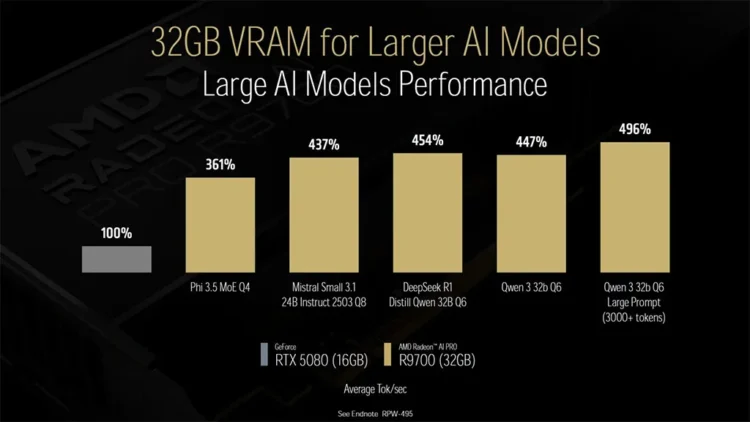

En tareas de IA, AMD comunica que esta tarjeta alcanza 191,4 TFLOPs en FP16 y 1531 TOPS en INT4 con sparsity. Esto supone el doble de rendimiento respecto a la Radeon PRO W7800 y hasta cinco veces más velocidad frente a la RTX 5080 en modelos que requieren más de 16 GB de VRAM. Según AMD, esta diferencia tiene impacto directo en resultados como generación de imágenes o tareas de razonamiento con modelos de gran tamaño.

La GPU admite configuraciones multi-GPU con plataformas PCIe 5.0, lo cual permite escalar hasta 128 GB de memoria efectiva. Esto amplía las posibilidades al trabajar con modelos como Mistral 123B o DeepSeek R1 70B, que superan los 112 GB de consumo de VRAM.

El soporte para instrucciones WMMA y sparsity estructurada optimiza las operaciones matriciales, claves en cargas de inferencia. Además, la integración con ROCm 7 refuerza la compatibilidad con entornos profesionales.

Se espera que la Radeon AI PRO R9700 esté disponible a partir de julio a través de distribuidores como ASUS, ASRock o Sapphire, en diseño de doble ranura con refrigeración tipo blower.

Desde nuestra perspectiva, esta tarjeta representa un avance técnico relevante para entornos de trabajo que exigen fiabilidad y rendimiento continuo. Observamos con atención su lanzamiento y futuras pruebas. ¿Estaremos ante un nuevo estándar para la IA local?